2018年,OpenAI发布了首个大语言模型GPT,揭开了大语言模型革命的序幕。这场技术浪潮在2022年11月因ChatGPT的问世而达到了新的高潮。短短一年内,大语言模型的生态系统迅速扩张,呈现出前所未有的活力。

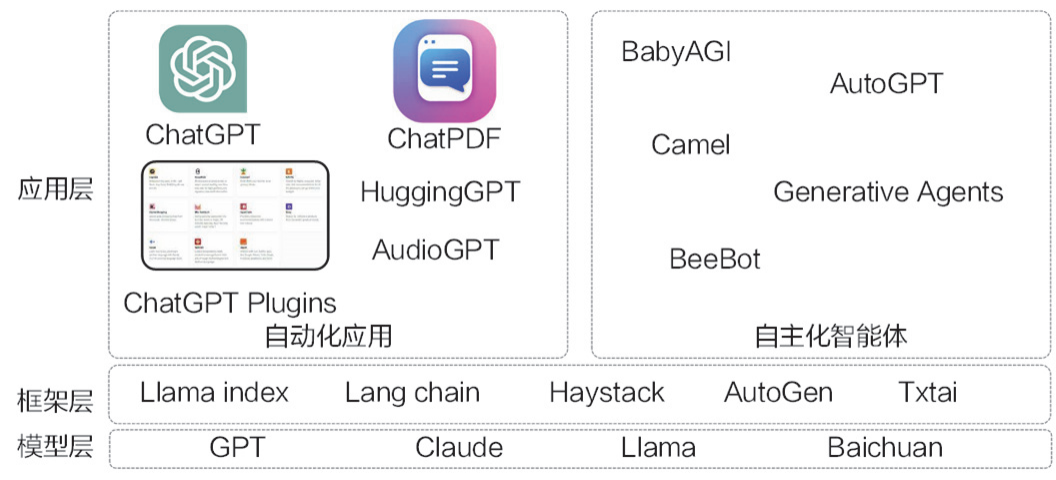

大语言模型的生态系统可以被划分为三个关键层次:模型层、框架层和应用层,如下图所示。 理解这三个层次的运作方式,能帮助我们更好地上手和掌握大语言模型,进行更有效的AI实践。

模型层是整个生态系统的基石,提供最核心的大语言模型能力。它包括开源和闭源两种模型。闭源模型的佼佼者是OpenAI的GPT系列和Anthropic的Claude系列。GPT系列模型在性能上无疑处于行业领先地位,远超其他同类模型。开源模型的代表则是Meta推出的Llama2。闭源模型如同移动互联网时代的iOS系统,上手简单,技术门槛较低;而开源模型则类似于Android系统,对使用者的技术水平有更高的要求,但提供了更强大的定制能力。无论是开源还是闭源模型,都支持模型微调,使开发者可以根据特定需求进行优化。OpenAI甚至提供了神经网络的文本向量化功能,为更高级的应用场景提供了可能。

框架层构建于模型层之上,提供基于大语言模型的开发框架,旨在帮助开发者更快地构建相关应用。目前,市场上涌现出众多优秀的开发框架,它们对大语言模型的二次开发进行了抽象,针对不同领域的需求提供了便捷的工具。除了开发框架之外,向量数据库、知识图谱等周边模块也扮演着重要的角色,它们为大语言模型提供了更丰富的数据支持和知识来源。

应用层是基于大语言模型开发的最终产品,ChatGPT无疑是其中最耀眼的一颗星。这些应用大致可以分为两类:一类是自动化应用,以ChatGPT为代表,需要人类的参与和反馈才能不断优化;另一类是自主Agent系统,例如AutoGPT,它们无需人工干预,可以在接收到初始指令后自主迭代和完善。应用层目前正处于快速发展阶段,特别是自主Agent系统,充满了无限的可能性和想象空间。个人认为,未来的应用将会更加智能化,更加贴近用户的个性化需求。

在了解了大语言模型的生态系统之后,让我们展望一下大语言模型的未来发展趋势。以下是一些基于当前发展态势的预测:

在应用层面,应用将朝着无状态、有状态以及具备自主决策能力的方向发展。自主Agent系统将成为一个重要的应用方向。目前,自主Agent系统的模块之间主要通过自然语言进行信息传递和状态存储。然而,未来这种方式可能会演变为神经网络编码的向量,从而提高信息传递的效率和精度。这种转变将会带来应用体验的飞跃,让AI更像是一个能思考、能决策的智能助手,而不仅仅是一个工具。

在框架层,不同框架对于基于大语言模型应用的基础模块抽象正在逐渐形成共识,例如对长期记忆和RAG(Retrieval-Augmented Generation)框架的抽象,以及对提示模板的抽象。这种趋势将有助于不同框架更好地协同发展,实现互相兼容,从而推动更广泛的应用和创新。如果能建立一个统一的标准,就能降低开发者的学习成本,加速整个行业的进步。

在模型层,大语言模型未来的发展可能集中在以下几个关键方向:

- 数据将是最重要的竞争优势,形成难以逾越的护城河,实现数据的循环增值。闭源大语言模型的制造商将不断探索新的产品形态,以积累更多的数据。例如,OpenAI通过ChatGPT的用户反馈(“赞”和“踩”)来评估模型回答的质量,甚至可以根据用户对同一问题的提问次数来粗略估计模型回答的质量。此外,OpenAI后续推出的Plugin等功能,也为function calling功能积累了高质量的、真实的涉及工具使用的训练数据。

- 上下文窗口的大小将持续扩展,但不必盲目追求无限扩展。通常,百万量级的token就足以支持大多数应用场景。同时,工程端会不断优化,降低大语言模型的使用成本,让更多人能够享受到AI带来的便利。

- 缓解幻觉和偏见问题将成为关键目标,这是大语言模型成为可靠系统的先决条件。一个可靠的AI系统才能真正被信任,并应用到更重要的领域。

- 逐渐支持多模态的输入和输出,为更多领域的应用带来创新和可能性。这将催生更多新型的提示工程,例如视觉参考提示。多模态的AI将能够理解图像、音频、视频等多种信息,从而更好地理解人类的需求。

- 不断探索突破自回归模型的局限性,尝试将系统2纳入训练框架,同时探索根据问题的难度自适应地分配计算资源,以提高效率和效果。无论是训练范式(目前主要是“下一个 token 预测”)还是神经网络结构,在未来都可能迎来全新的变革。

2023年11月,OpenAI的创始成员Andrej Karpathy提出了一个极具启发性的观点:未来,大语言模型极有可能发展到与当前计算机操作系统的地位相当。这并非天方夜谭,而是对AI发展方向的一种深刻洞察。

他巧妙地将大语言模型及其周边生态系统比作一种崭新的操作系统,这种类比非常贴切,有助于我们理解大语言模型在未来可能扮演的角色。

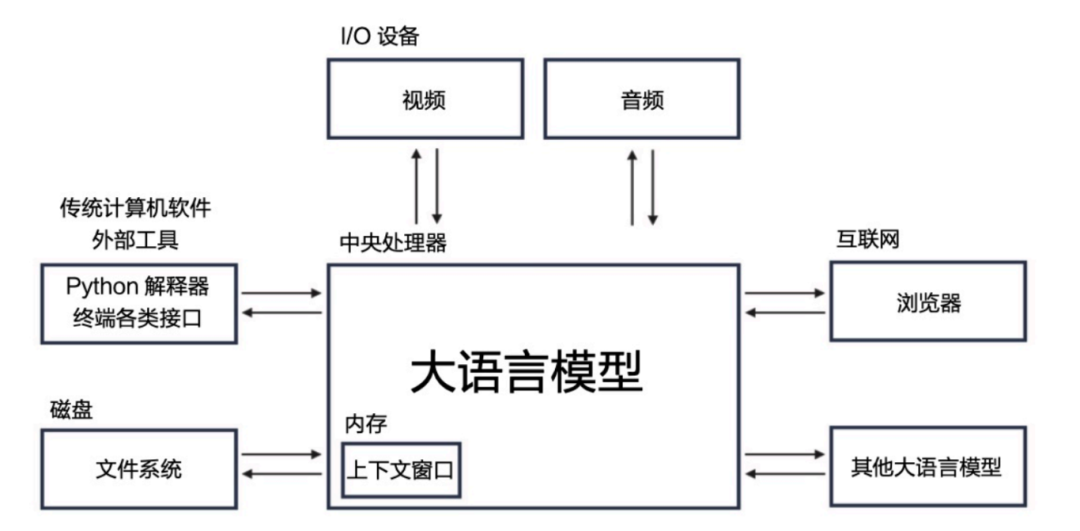

大语言模型就像计算机的中央处理器(CPU),它的批处理大小相当于CPU的核心数,而每秒处理的token数量则相当于CPU的主频,以Hz为单位。这些参数直接决定了模型的计算能力和处理速度。语言模型的上下文窗口大小则类似于计算机的内存大小,它决定了模型能够同时考虑的信息量和短期记忆容量。

外部数据在语言模型中扮演着长期记忆的角色,如同计算机的磁盘。这些外部数据的组织方式就像计算机磁盘中的文件系统一样,它们存储和管理着模型需要的信息,供其随时调取。此外,语言模型接收和输出的文本、音频、视频相当于计算机的输入输出设备,它们是模型与外界交互的媒介。

更重要的是,大语言模型不仅可以与其他模型进行网络通信,还能够通过浏览器访问互联网上的信息,以及利用外部工具执行传统的计算机操作。这种广泛的连接和应用使得语言模型在信息处理和应用方面具有了前所未有的能力和灵活性,也使其具备了成为新一代操作系统的潜力。

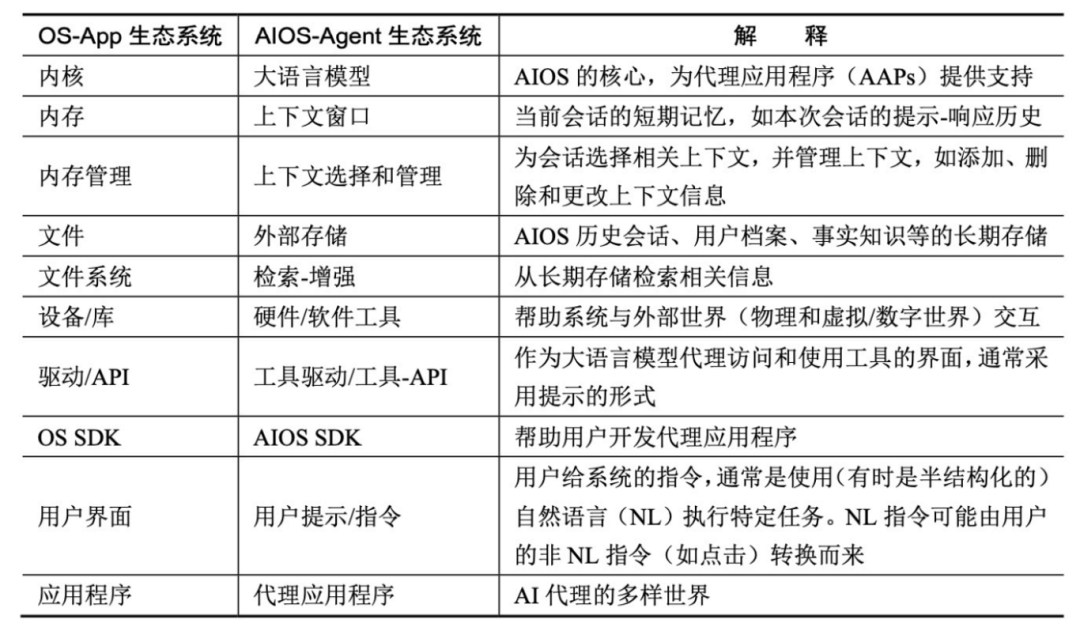

LLM as OS, Agents as Apps: Envisioning AIOS, Agents and the AIOS-Agent Ecosystem论文的作者也持有与Andrej Karpathy相似的观点,他们的研究进一步印证了这种可能性。

在这篇论文中,作者提出了AIOS-Agent生态系统的概念,并将其与现今的操作系统(OS) -应用程序(App)生态系统进行了深入的比较,为我们理解大语言模型的未来发展提供了新的视角。

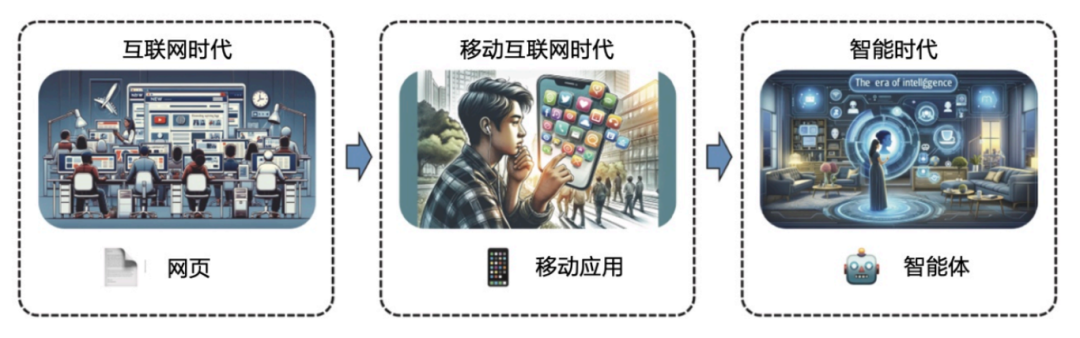

展望未来,大语言模型极有可能以这种全新的形态融入人类的日常生活和工作中。人类将从移动互联网时代迈入智能时代,应用的载体也将由应用程序逐渐转变为基于大语言模型的智能体。这意味着,未来的应用将更加智能化、个性化,能够更好地理解和满足用户的需求。

可以预见,大语言模型极有可能发展到与当前计算机操作系统的地位相当,因此,掌握应用大语言模型的能力将成为每个人不可或缺的技能。未来,不懂AI就像现在不懂电脑一样,将会被时代所抛弃。

《大语言模型应用指南:以ChatGPT为起点,从入门到精通的AI实践教程(全彩)》一书将帮助大家更好地理解和使用大语言模型,即使你对人工智能技术或编程技术一窍不通,也不用担心。本书将用通俗易懂的语言和例子,讲述大语言模型的基本原理、基础使用方法和进阶开发技巧,带你快速入门并精通AI。

本书特色

- 一是以通俗易懂的方式解释复杂概念,通过实例和案例讲解大语言模型的工作原理和工作流程、基本使用方法,包括大语言模型常用的三种交互格式、提示工程、工作记忆与长短期记忆,以及外部工具等,使读者能够全面了解和掌握这一先进技术的应用和二次开发。

- 二是紧跟当前大语言模型技术的更新动态,介绍GPTs的创建,以GPT-4V和Gemini为例讲述多模态模型的应用,还包括无梯度优化、自主Agent系统、大语言模型微调、RAG框架微调、大语言模型安全技术等。

无论是学术研究者、工程师,还是对大语言模型感兴趣的普通读者,都可以通过本书获得大语言模型的前沿研究成果、技术进展和应用案例,从而更好地应用大语言模型解决实际问题。这本书不仅是一本技术指南,更是一扇通往未来的大门,带领读者进入AI的奇妙世界。

AI教程总结

总而言之,本篇AI教程文章深入浅出地介绍了大语言模型,特别是以ChatGPT为代表的应用,从生态系统的构成、未来发展趋势,以及如何从入门到精通地掌握AI实践技能。通过类比操作系统和应用程序,帮助读者更好地理解大语言模型在未来可能扮演的角色,并强调了掌握AI技能的重要性。无论是初学者还是专业人士,都能从中受益匪浅。